I år bruker Norge omtrent 41,6 milliarder kroner på offentlig forskning[. Det er forståelig at samfunnet til gjengjeld for denne store investeringen ønsker å måle hva de får igjen for pengene. Og det gjøres og blir presentert i nettsider med offentlig statistikk og i ulike rapporter og artikler, for eksempel Forskningsrådets årlige Indikatorrapport og Kunnskapsdepartementets årlige «Tilstandsrapport for høyere utdanning» og Forskningsbarometer. Til sammen skal disse gi et nyttig, meningsfullt, ikke-fordreid og komplett bilde av status innen høyere utdanning og forskning.

Men så enkelt er det selvfølgelig ikke, og indikatorbatteriet, og ikke minst bruken av det, tellekantsystemet, er derfor og med gode grunner diskutert oppad stolper og nedad vegger. Er indikatorene nyttige? Nyttige for hva? Gir de et balansert eller forvrengt bilde? Fremmer de interessene til noen institusjoner eller grupper over andres? Er de meningsfulle? Blir de “misbrukt”, i den forstand at de ulike indikatorene blir vurdert hver for seg og ikke sett i sammenheng med hverandre? Listen av spørsmål er lang som et vondt semester.

Indikatorene som ikke bare gir minst mening, men også dessverre skaper kontraproduktiv aktivitet, er de som måler forskningsproduksjon per akademisk ansatt uten å justere for faktisk forskningstid. Vi kan finne mange eksempler på dette i artiklene i sektoren, for eksempel i Khrono (“Idrettshøgskolen best av alle på publisering” , “Bergen passerte Oslo på mest EU-midler”, “Får mest fra Forskningsrådet per faglige årsverk”), og senest i Universitetsavisa («Torsdag legger han fram en dyster statistikk for NTNU-styret»).

Et eksempel er når man forveksler publiseringsproduktivitet med antall publiseringspoeng per UFF-ansatt. Dersom både Per og Mari blir målt på hvor mange artikler de produserer, men Mari bare får bruke halvparten så mye tid på forskningsproduksjon som Per, er det selvfølgelig urimelig å måle produktivitet i form av antall artikler i året. Man må justere for faktisk forskningstid. Og slik er det også når man akkumulerer dette opp på institusjonsnivå.

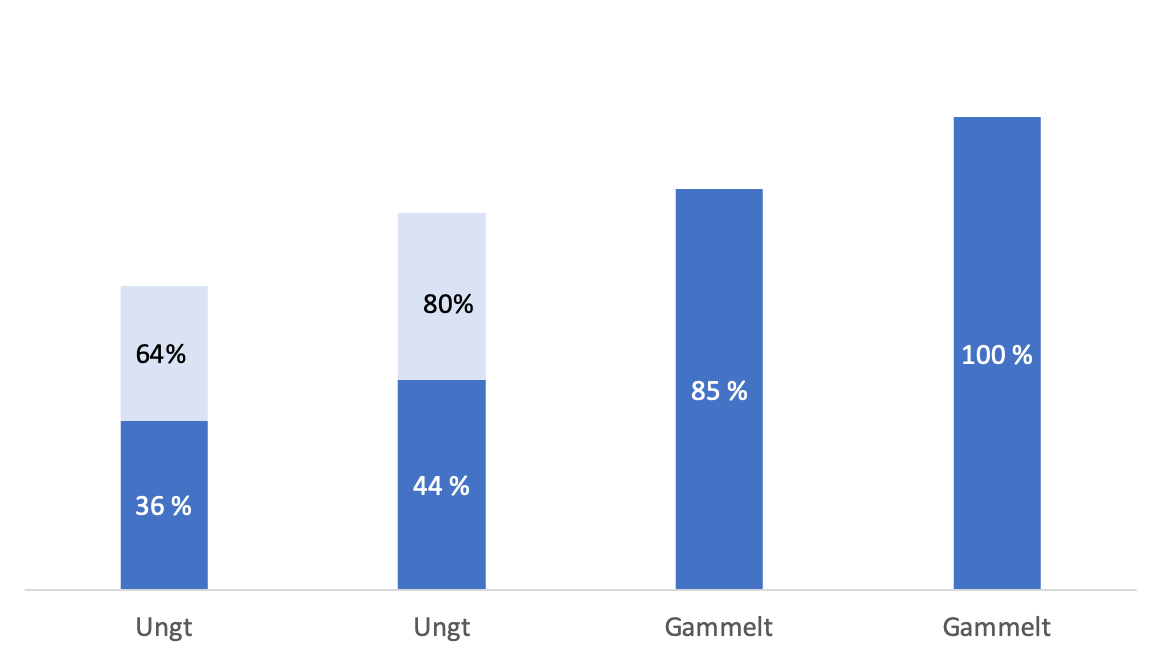

Grafen under illustrerer hvor substansielt feil målemetoden er. Figuren illustrerer publiseringsproduktiviteten til de to eldste og de to yngste universitetene. Her er produksjonen av publiseringspoeng per UFF-tilsatt satt som en prosent av produksjonen til den mestproduserende av disse fire. De to yngste universitetene våre har en produksjon av publiseringspoeng per UFF som er henholdsvis 36 og 44 prosent av produksjonen til det mestproduserende universitetet. Beregningene er gjort med utgangspunkt i data fra DBH.

Men justerer vi for forskningstid per årsverk for UF-ansatte, ser vi en helt annen situasjon. Da er publiseringsproduktiviteten ved de to yngste universitetene henholdsvis 64% og 80% av det mestproduserende universitetet. Vi har her antatt at den gjennomsnittlige FOU-tiden ved de to yngste universitetene er omtrent 25% (som er tilfelle for OsloMet), og ved de to eldste universitetene omtrent 45%.

Selvfølgelig er det umulig å ta hensyn til alle faktorer som influerer en indikator. Man bør allikevel strebe etter å konstruere indikatorer som er så meningsfullt sammenlignbare på tvers av institusjonene som mulig. Det mest opplagte, og som i tillegg er enkelt å få til, er å justere for tiden man har allokert for oppgaven som indikatoren måler.

Velger vi indikatorer ut fra hva vi enkelt har tall på eller ut fra vi faktisk burde måle? Noen av de viktige indikatorene i tellekantsystemet til UH-sektoren tildekker i stedet for å avdekke, og krever for mye forklaring til at de er nyttige. De er ikke bare meningsfattige, de er også skadelige. Feilrepresentasjon av sektorens institusjoner kan både føre til at beslutninger blir tatt på feil grunnlag, og være demotiverende.

Det er først når vi har ryddet unna et aspekt som umuliggjør sammenlikning at vi kan begynne å lete etter mening bak forskjellene. Da kan vi forstå at forskningens overheadsandel korrelerer negativt med forskningstiden, at forskningsperiodenes lengde korrelerer positivt, og at finansieringen til de eldre universitetene muliggjør en sterkere administrativ og strategisk forskningsstøtte og substansielt flere postdoktorander og stipendiater. Og da kan vi bruke slik innsikt til å styrke effekten av ressursene våre, med andre ord øke produktiviteten og kvaliteten.

Denne artikkelen ble oppdatert 7/6 2019 med en graf og referanse til flere artikler. Ellers, se en liten allegori i en tidligere artikkel, om hvordan man i en bindersfabrikk kan forveksle produksjon og produktivitet.